AX: что меняется в дизайне и почему это важно

Дизайн-директор компании

Intelsy Костя Зудов поразмышлял о том, как меняется роль дизайна в мире, где на первый план выходят голосовые ассистенты и GPT-системы вроде GPT. Мысли интересные, обсуждения по классике в комментариях.

Вместо предисловия

За последние десятилетия дизайнеры выстроили удобный цифровой мир: кнопки, формы, экраны, понятные сценарии. UX научил нас делать сложное понятным и помог миллионам пользователей быстрее решать свои задачи. Но сейчас мы наблюдаем заметный сдвиг. Пользователь всё чаще хочет не нажимать — а просто сказать, что нужно.

Не искать фильтр — а сказать:

«Алиса, включи Лед Зеппелин»,

«Покажи ближайшие кофейни»,

«Забронируй столик у окна на 19:00, но без громкой музыки».

Это уже не UX в привычном смысле. Это другое взаимодействие — без экранов и интерфейсов. Пользователь формулирует намерение, а система сама выбирает, как к нему прийти. Это называется AX — Agent Experience.

Что такое AX

AX — это опыт взаимодействия с цифровым агентом: ИИ, голосовым помощником или чат-ботом. У пользователя есть задача, система — понимает и делает. Весь процесс можно описать так:

1. Пользователь формулирует запрос

2. Система распознаёт намерение

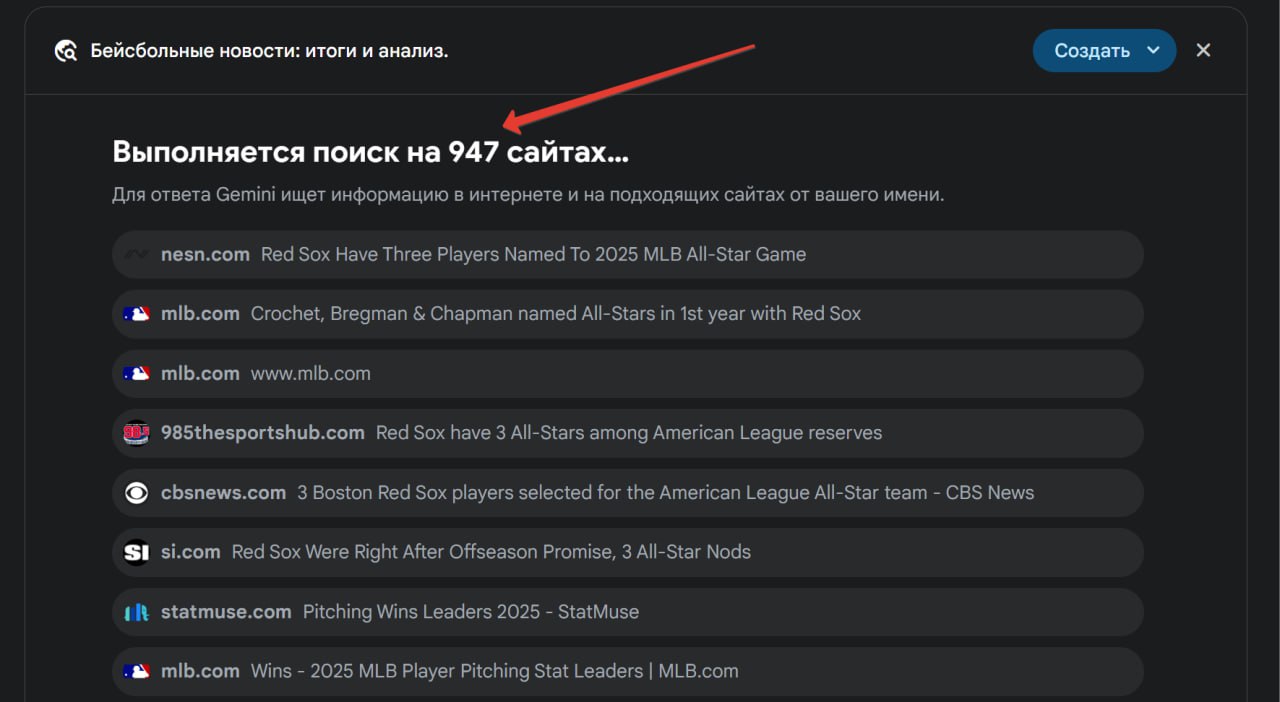

3. Агент (например, GPT) подбирает нужные действия

4. Выполняется задача

5. Пользователь получает результат и при необходимости корректирует его

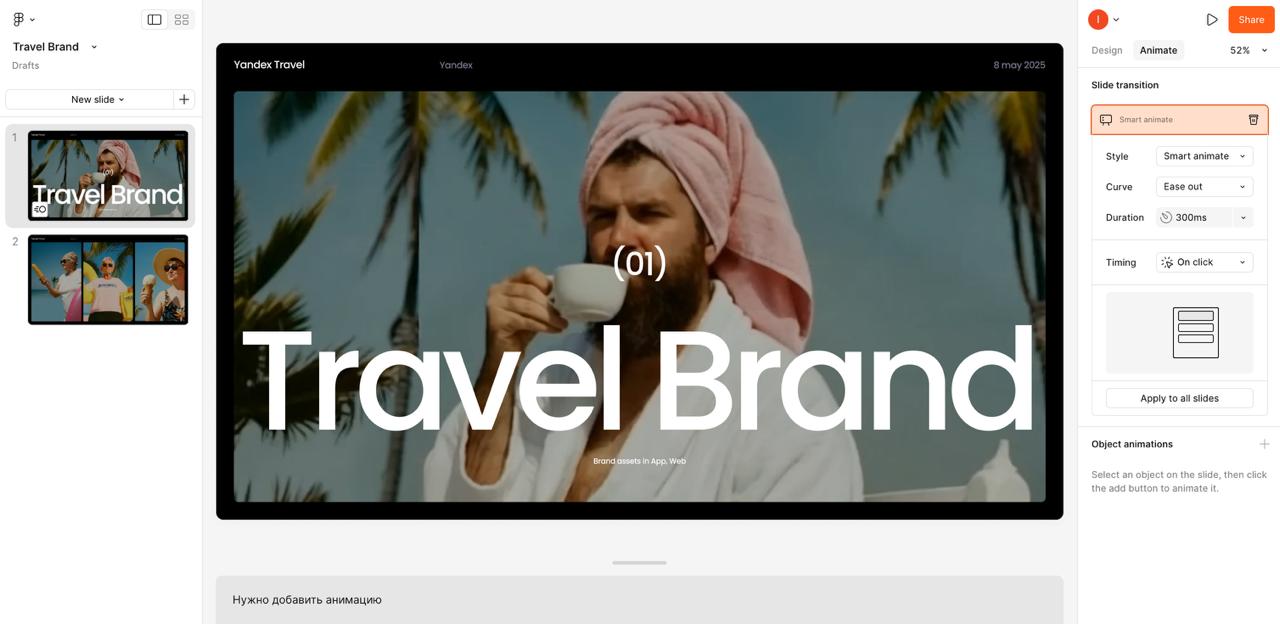

В отличие от UX, где всё завязано на сценарии и кнопки, AX — это гибкий, контекстный диалог. Если вы пользовались ChatGPT, говорили «Окей, Google», или создавали презентацию в Canva Magic — вы уже сталкивались с AX. Даже в Figma можно просто описать экран словами — и получить заготовку. Это уже не интерфейс — это взаимодействие.

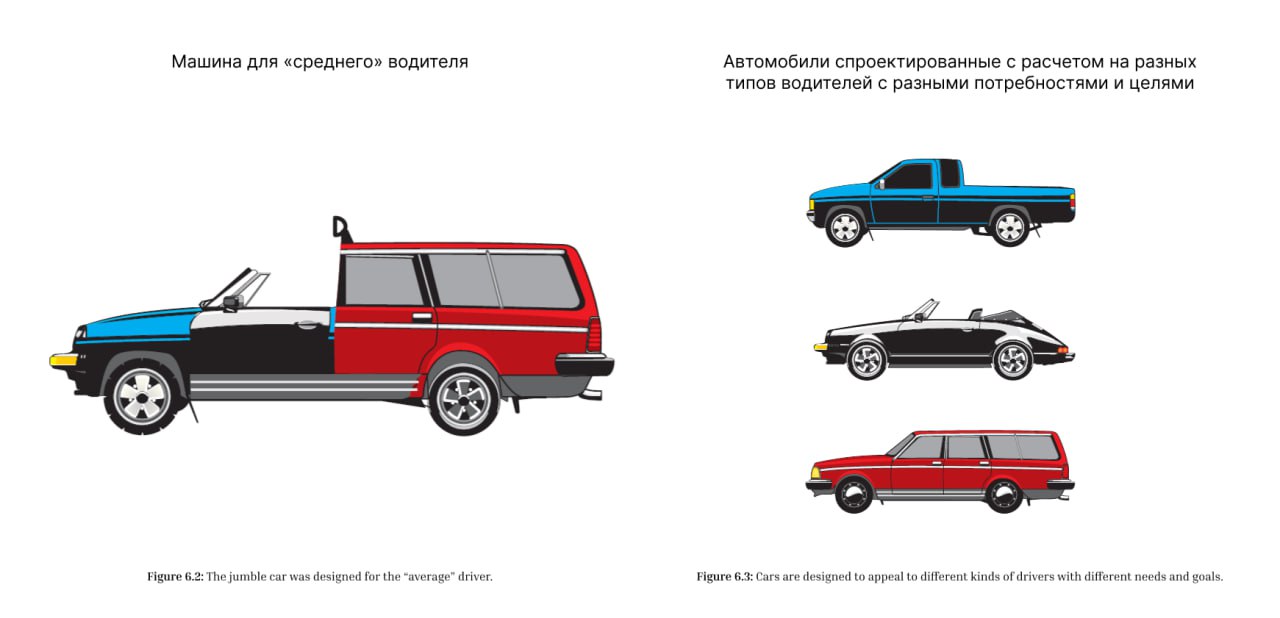

AX не заменяет UX, но сильно меняет фокус. Раньше дизайнер проектировал маршрут пользователя. Теперь — логику того, как система будет понимать задачи.

Тут уже нужны другие навыки:

— Понимание намерений, а не только визуальных паттернов

— Работа с логикой и ситуациями, а не с кнопками

— Знание, как устроены LLM (большие языковые модели)

— Умение проектировать поведение и реакцию системы, а не только макеты

Что дальше

AX — не модный термин. Это смена логики. Как когда-то мы перешли от кнопочных телефонов к смартфонам, так сейчас переходим от интерфейсов к интерактивному диалогу. Интерфейсы никуда не исчезнут — но они станут вторым уровнем.

На первом будут: контекст, язык, смысл.

И тем, кто продолжит проектировать только визуальные слои, будет всё сложнее конкурировать. Потому что новая ценность создаётся уже не там.

Что можно делать уже сейчас

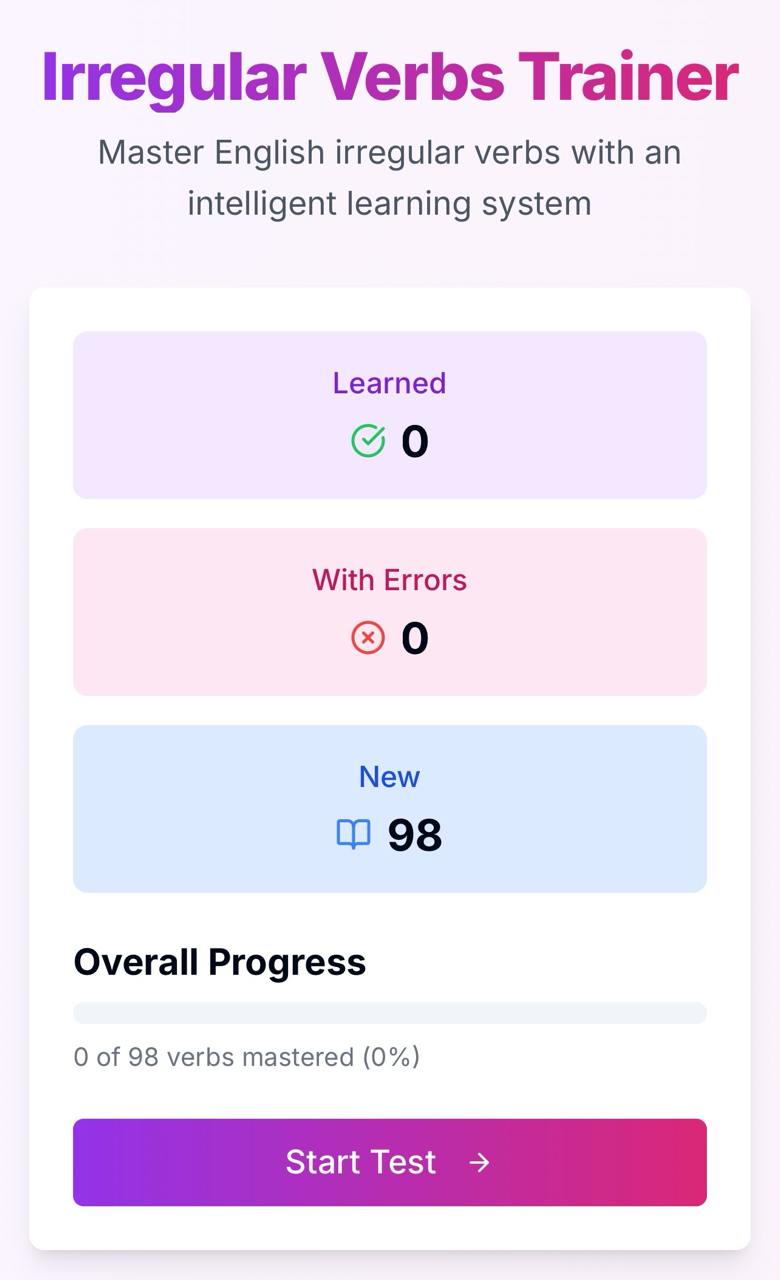

— Изучите, как работают агенты: GPT, Claude, голосовые ассистенты

— Освойте основы prompt engineering

— Попробуйте собрать собственного телеграм-бота или протестировать простого агента

— И главное — начните задавать себе вопросы: Что должен понимать агент? Как он должен реагировать? Что будет с дизайном, когда кнопок не станет?

Вместо итога

Пользователь всё чаще не нажимает — а говорит.

Система всё чаще не предлагает путь — а сразу решает.

Если вы занимаетесь дизайном — подумайте, как к этому адаптироваться.