15+ секретов успешного салона красоты: от дизайна до прибыли

Почему одни салоны притягивают клиентов как магнит, а другие, несмотря на шикарный ремонт, простаивают? Ответ кроется в деталях, о которых многие даже не подозревают.

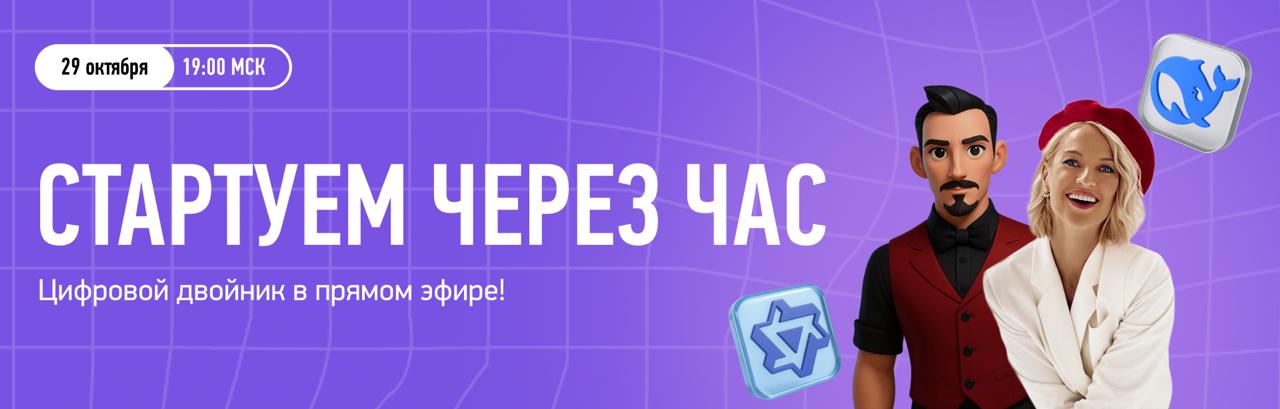

Мы собрали для вас эксклюзивный эфир с двумя экспертами индустрии красоты: Татьяной Остапчук – гуру систематизации бьюти-бизнеса, и Дарьей Крыливской – дизайнером, создавшей более 500 успешных проектов, включая студии Дилары, Ханны, сети "Персона" и сети "Пальчики".

На эфире вы узнаете:

1. Чек-лист: 5 признаков, что салон ворует прибыль

2. С чего начать открытие салона или клиники?

3. Что важно учесть в бизнес-сегменте при проектировании?

4. Что критически важно в премиум-сегменте?

5. Что делать, если салон уже работает, но ощущение, что что-то не то?

6. Сколько времени уходит на обновление без закрытия салона?

7. Что делать, когда интерьер выглядит красиво, но все «не то»?

8. Как правильно зонировать пространство в салоне?

9. Какой цвет использовать, чтобы не устарел через 2 года?

10. Что влияет на продажи в салоне?

11. Какие цвета провоцируют на покупку?

12. Как обустроить зону ожидания в салоне?

13. Что нужно учитывать при проектировании клиник?

14. Салон с окнами в пол – красиво, но не работает. Почему?

15. 5 признаков, что Вам точно пора обновить салон.

16. Вопросы от участников эфира.