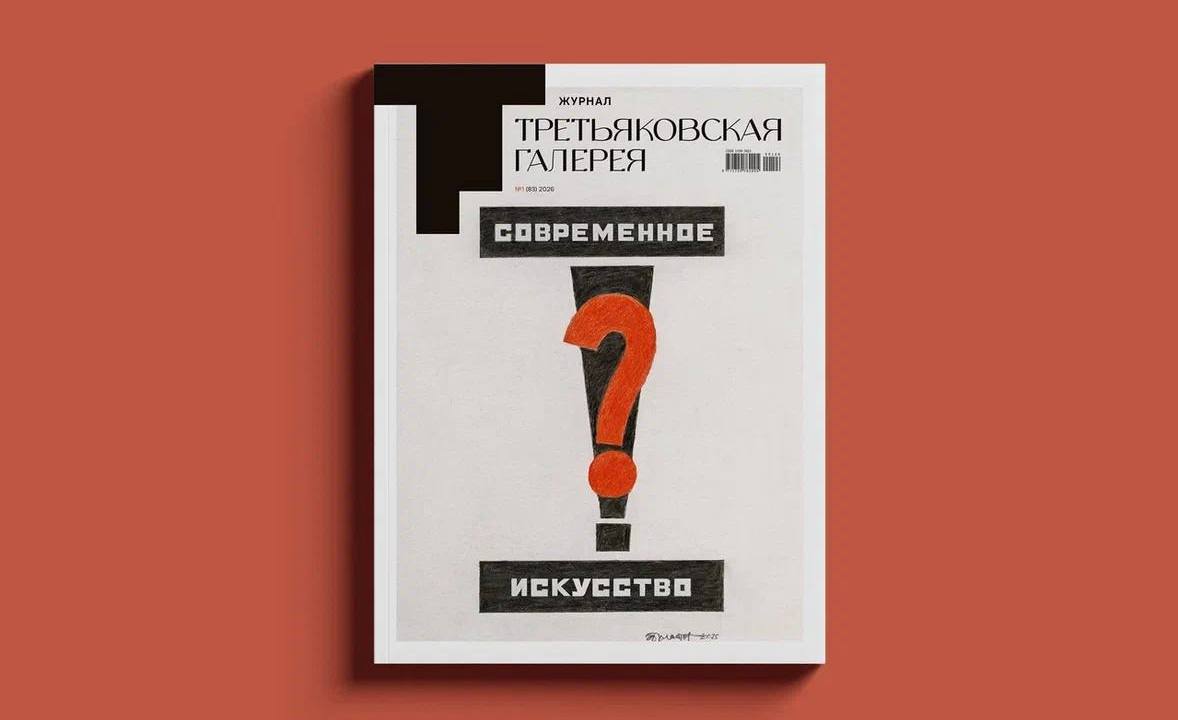

пишу этот пост как главный редактор журнала «Третьяковская галерея». Полтора года назад меня пригласили обновить его после 23-летней славной истории. До этого он был посвящен только Третьяковке. Мне хотелось, сохраняя ГТГ в приоритете, сделать единственное издание о музейной и художественной жизни страны. Хотелось, чтобы у нас наконец появилась платформа для диалога, поддержки и развития российского искусства и музейного дела.

Анонсирование журнала состоялось на Питерском культурном форуме на следующий день после выступления президента, где он отметил важность преемственности поколений. И наша редакция, и список приглашенных авторов поровну состоят из зрелых и молодых кадров. От 21 до 76. Юные таланты мы отыскивали на конкурсной основе в лучших вузах и принимали их в команду, среди которой выдающиеся искусствоведы, критики и выходцы из Conde Nast.

Нам — молодым и опытным ученым — близок научный подход. Поэтому мы выбрали следующий формат: 1 фундаментальная тема = 1 номер. Ее раскрывают 30 разноформатных текстов от академических статей с научными открытиями и круглых столов до чек-листов, таймлайнов и детского блока с азбукой искусства. У нас много прикладных форматов для неофитов, ведь мы избрали не снобский тон, а формулу — научно и доступно — для самой широкой аудитории. Это можно сделать только, когда авторы сами любят искусство, знают его и умеют говорить о нем простым языком. Именно такие они у нас!

Форма должна быть под стать содержанию. И ее изящно вывел наш арт-директор Дмитрий Гиенко с отсылкой, с одной стороны, к васнецовскому фасаду Третьяковки, с другой — к архитектонам Малевича. Он мастерски сплел традицию и авангард. Разработал стильную, дышащую верстку с уважением к авторам и художникам.

Первой темой номера мы выбрали современное искусство, для которого и создавалась когда-то ГТГ. Обложку согласился создать специально для нас Эрик Булатов. Наша работа стала его последней и в каком-то смысле завещанием. Он точно отобразил тему выпуска — «Что такое современное искусство», дополнив вопрос восклицанием. Эрик тогда сказал: «Мы должны бороться за наше современное искусство и утверждать его! Пообещай, что будешь это делать».

Мы задумали его на самом высоком уровне, в том числе полиграфическом — как коллекционное издание. Каждый из 5000 экземпляров прошивался вручную. Это дает 100-процентную раскрываемость разворота и не теряются 5–10 мм изображений. Эффект усиливает лучшая на нашем рынке бумага и максимально точная цветопередача. Тут постарались наши препресс и технологи самой сильной сегодня в России типографии «Август Борг».

К чему такие детали, спросите вы? К тому, что я расскажу про этот журнал только один раз. Потому что ему не суждено выйти в такой версии. В ГТГ сменилось руководство. У нового директора свое видение концепции журнала — исключительно про Третьяковку. И её можно понять: что бы ни вышло сегодня под брендом ГТГ, все равно будет ассоциироваться с ней. Поэтому было решено снять с предзаказа номер и вместе пересмотреть концепцию журнала. Что будет дальше, время покажет…

Пока же говорю спасибо тем, без кого этот «ребенок» весом в 1,5 кг и объемом в 208 полос не родился бы. Отдельное спасибо — Эрику Булатову. Эрик, если ты меня слышишь, знай, я сдержала обещание