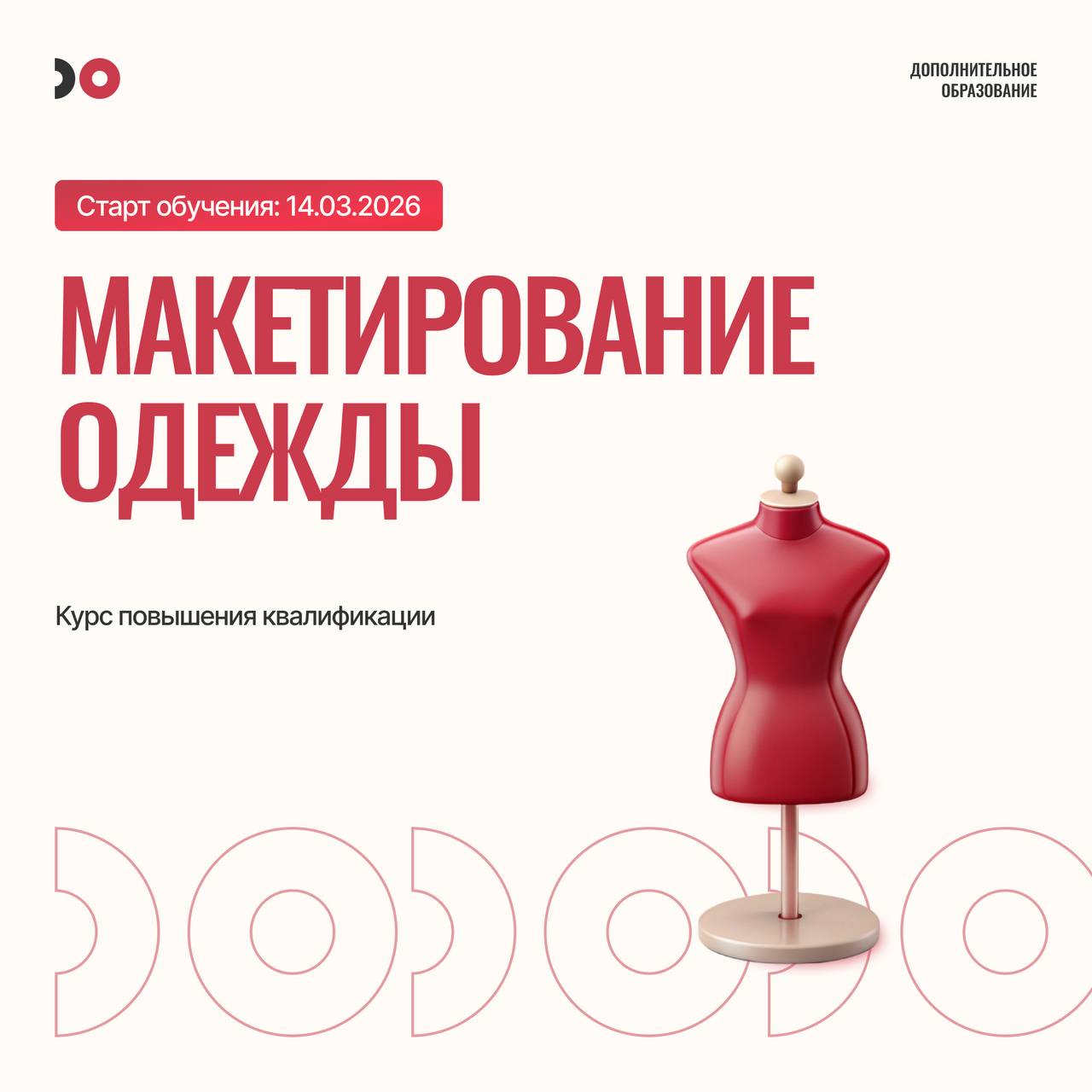

Классный шрифт в Nano Banana

3D typography of the words "Рождественские Шрифты" in luxurious velvet letters in a deep burgundy.

The velvet texture is soft, with visible fibers and velvety shadows.

Some of the surface is fluffier, almost fur-like, creating the effect of soft winter textiles.

Embellishments:

• a thin gold garland with warm mini-lights gently wraps around the letters,

• subtle gold sparkles and reflections on the velvet,

• harmonious accents: tiny gold stars, subtle shimmer.

Background:

• a deep, premium burgundy background, slightly darker than the letters,

• a soft gradient or smooth velvet texture for a cohesive atmosphere.

Lighting:

• gentle backlighting highlighting the furry edges,

• soft, warm frontal lighting creating volume. Style: ultra realistic, 8K, rich velvet texture, cinematic glow, luxury holiday aesthetic, premium color palette.

Инструкция:

1) заходим в Бот синткс

2) выбираем Дизайн с ИИ - Nano Banana Pro.

3) отправляем промпт , заменяя мой текст и готово!